30 Meilleur test Playmobil Station Service en 2022: après avoir recherché des options

Vous recherchez des conseils d’experts pour acheter le meilleur Playmobil Station Service? Les experts sont ici avec la liste des Playmobil Station Service les mieux notés disponibles en France pour 2022.

Vous allez investir votre argent durement gagné en achetant ce Playmobil Station Service et ne voulez pas que vous le regrettiez. C’est pourquoi j’ai passé beaucoup de temps à rechercher, réviser et comparer. Pour enfin accéder à cette liste!

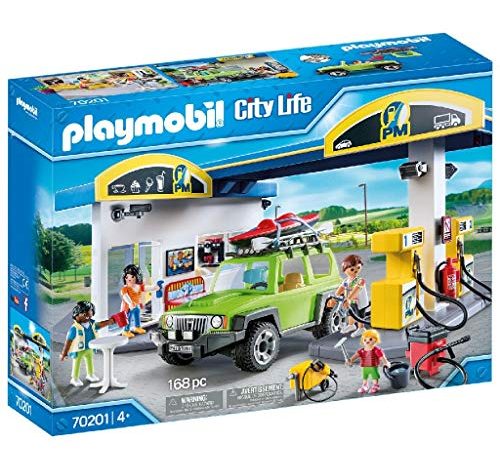

Features

- comprend des pompes à carburant pour Les voitures et pour Les camions.

- - Le 4X4 est équipé d'un crochet d'attelage de remorque et d'une ouverture de réservoir.

- Le toit est amovible.

- Le véhicule tout-terrain comprend deux places pour Les personnages.

Features

- Après différentes recherches, les astronautes Playmobil sont désormais en route pour explorer la planète mars au cours d'une passionnante mission spatiale.

- La station spatiale mars a été développée pendant de nombreuses années de préparation pour cette mission afin d'être préparé au mieux à la reconnaissance de cette planète.

- Convient aux enfants de plus de 6 ans.

- Avec deux astronautes, un robot, un lance-missile mobile, Ainsi que de nombreux effets lumineux et sonores. Dimensions: 50 x 28 x 20 cm (L x P x h).

- Rejoins notre équipe d'astronautes, techniciens et robots !

Features

- Cet article fait partie de la gamme Playmobil Direct Service (série complémentaire). Les articles de cette gamme sont emballés dans un sac en plastique transparent ou une boîte marron. Ils ne sont pas livrés dans un emballage coloré. Veuillez noter cela lors de l'offrir. Les articles de cette gamme sont destinés à être utilisés en tant qu'accessoire ou en complément des kits Playmobil existants. La gamme est de plus en plus populaire et peut certainement être appréciée comme un article autonome.

Features

- Aujourd'hui, on fête un anniversaire !

- Il y a des ballons, des muffins, des cadeaux et même un clown.

- Convient aux enfants à partir de 4 ans.

- Avec 4 personnages de nombreux accessoires pour une fête réussie : course en sac, corde à sauter, balancelle…

- Une belle et grande maison pour accueillir toute la famille et y faire plein d'activités !

Features

- Le moteur du cabriolet tombe en panne, heureusement, le garage n’est pas loin !

- Le chef d’atelier a justement un moment de libre et peut regarder le moteur.

- Convient aux enfants à partir de 4 ans.

- Avec plate-forme élévatrice et équipement complet de garage. Cabriolet inclus. Avec un personnage.

- De la vitesse aux utilitaires, choisis le véhicule adapté à ton histoire !

Features

- Recréez l'univers du Poney Club avec vos animaux préférés, de nombreux accessoires sont inclus pour imaginer encore plus d'histoires.

- Découvrez toute la gamme Poney Club

- Les jouets Playmobil sont parfaits pour les enfants à partir de 5 ans car leur taille est adaptée aux petites mains des enfants.

- L'entretien des jouets Plamyobil se fait à l'eau sans produits chimiques. Tous les éléments sont robustes et de haute qualité.

- Contient trois personnages, deux chevaux et de nombreux accessoires.

Features

- L'incroyable Stuntshow Playmobil est l'évènement où tous les cascadeurs rêvent de performer ! Ce spectacle haut en couleurs impressionnera tous les petits et les grands fans de cascade et de vitesse !

- Le mécanicien du Stuntshow est un véritable expert, aucun problème mécanique ne lui résiste. Peut être combiné avec la StuntShow Voiture crash-test.

- Avec la figurine mécanicien et ses accessoires, les enfants laissent parler leur créativité et imaginent une multitude d’aventures !

- Grâce à son atelier bien équipé, il peut réparer les véhicules en un rien de temps ! Mais ce qu’il préfère par dessus tout, c’est bricoler sa moto.

- Contient un personnage, une moto, une tente, un plateau élévateur, un masque de soudure, des huiles, une caisse à outils, etc

Features

- La gamme PLAYMOBIL Dragons permet aux enfants de recréer et de continuer les aventures de leurs héros préférés dans leurs chambres !

- Les ailes du dragon sont mobiles et sa mâchoire peut être ouverte et fermée

- Le coloris unique du dragon lui donne un style à toute épreuve

- Rustik peut s'installer sur Krochefer pour partir à l'aventure

Features

- Centre de commandement avec liaison radio.

- La Voiture de policiers avec gyrophare et sirène réf. 6920 peut se garer dans la cour du commissariat.

- Comprend un mur cassable pour l'évasion.

- Le portail s'ouvre en coulissant.

- Avec armoire de rangement pour les armes des policiers, vêtement de prisonnier, boîte pour prise d'empreintes digitales et de nombreux accessoires.

Features

- Taille : 30.5*11*10.5 cm (Camion transporteur), 16.5*7*6 cm (Voiture de course). Matériel: plastiques. Durable, sûr et non toxique. Convient pour le jeu intérieur et extérieur. Convient aux enfants garçons et filles de plus de 3 ans.

- Avec lumières et sons: Avec des lumières clignotantes et différents effets sonores. Différents sons peuvent être appliqués à différentes scènes. Développer les compétences audiovisuing de l’enfant.

- Grue Jouet Enfant: Appuyez sur le bouton pour gazer le jouet de voiture, le jouet de voiture de course peut être soulevé. Appuyez sur un autre bouton, la voiture peut être mise vers le bas. Exercez la capacité de coordination œil-main de l’enfant.

- Voitures à friction : Le camion jouet peut parcourir une longue distance lorsque l’enfant pousse le jouet camion transporteur vers l’avant. Plaisir sans fin pour votre enfant sans avoir besoin d’une batterie.

- Meilleur cadeau pour les enfants: Approprié pour jouer dans la fosse de sable, jardin, extérieur ou intérieur. Idéal pour les cadeaux d’anniversaire et de Noël pour les enfants garçons et filles 3 4 5 6 ans.

Features

- Contient 1 maison, 2 personnages, 1 chien et des accessoires (barbecue, table, chaises, transat, pot de fleurs Lechuza, vaisselle)

- Comprend du mobilier pour la terrasse

- Toutes les portes peuvent être ouvertes dans les deux directions

- Dès 4 ans

Features

- En route pour la compétition !

- La cavalière, son fils et leurs deux chevaux partent remporter des rubans Rosette à bord de leur Porsche Macan GTS équipée d'une remorque à chevaux.

- Convient aux enfants de plus de 4 ans.

- Avec remorque pour cheval, attelage de remorque rétractable et de nombreux accessoires. Dimensions (Porsche) : 28,5 x 12,5 x 9,5 cm (LxPxH).

- Transforme ta chambre en circuit de course avec les voitures Porsche Playmobil !

Features

- Oh mince ! Une malade a besoin de se faire opérer.

- Il faut l'emmener au bloc opératoire, le plus vite possible.

- Convient aux enfants à partir de 4 ans.

- Contient trois personnages et de nombreux accessoires (nécessite 1 pile AAA de 1,5 V non fournie). Dimensions : 70 x 31 x 34 cm (LxPxH).

- Les habitants ont besoin de toi, viens vite nous aider à les soigner à l'hôpital !

Features

- Plaisir de jeu pour les petits héros du quotidien : Playmobil Grande école avec décor

- 9 figurines, 2 étages, escaliers

- Jeu de figurines pour enfants de 4 à 10 ans

- Utilisation quotidienne : instructions de montage avec les parents

- Contenu de la livraison : 1 x Playmobil City Life Grande école avec instructions

Features

- Le Volkswagen T1 est une icône de la route !

- Le toit est amovible

- Adoré par des générations, d'innombrables aventuriers ont parcouru le monde dans ce camping-car

- Contient deux personnages et des accessoires

Features

- - Le véhicule est compatible avec la radiocommande réf.6914 (la combinaison avec les anciens modules RC n'est PAS possible).

- Le toit est amovible.

- La cabine comprend deux places pour Les personnages.

- - Le bouton sur le gyrophare permet d'activer les effets lumineux (2 piles CR 2032 3V incluses). Arrêt automatique après 3 minutes.

Features

- Farm avec Silo

- Avec fonction lumineuse pour ne pas geler la porcelaine.

- Treuil pivotant et coulissant

- Silo rechargeable et facile à vider

- 3 figurines avec de nombreux accessoires

Features

- Avec trois personnages, un camping-car, un canoë, un quad, un chien et des accessoires (vélos, table, barbecue…).

- Le canoë flotte.

- Le toit du camping-car est amovible.

- Les vélos peuvent être rangés dans le camping-car.

Features

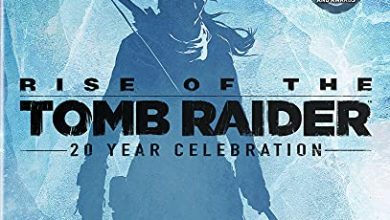

| Part Number | GXP-813717 |

| Is Adult Product | |

| Language | Anglais |

Features

- produit 1: Étant donné les nombreuses compétences du service d'incendie PLAYMOBIL, les pompiers ont également besoin de beaucoup de véhicules.

- produit 1: Heureusement que le 4x4 robuste est désormais disponible.

- produit 1: Convient aux enfants de plus de 5 ans.

- produit 1: Avec treuil, canon à mousse pour éteindre les incendies, module lumineux et sonore. Dimensions: 26 x 12 x 17 cm (L x P x H).

- produit 2: Plaisir de jeu pour les petits héros : pompiers Playmobil avec pompe à extincteur fonctionnelle et de nombreux accessoires pour jouer avec précision dans les détails

Features

- Le Pick Up est équipé d'un raccord Anh Nger.

- Le véhie n'est pas RC pour hig.

- Pour installer la caravane, les deux supports arrière sur la partie inférieure ainsi que la roue jockey sur le timon arrière sont dépliés.

- Le toit de la caravane est amovible.

- Espace de rangement supplémentaire disponible dans les tiroirs extérieurs latéraux et le compartiment rabattable au-dessus du timon arrière.

Features

- Ce set de construction de grue de chantier inclut une grue jouet avec des pieds mobiles, une flèche et un treuil placés sur un camion jouet à 6 roues

- Après avoir placé le camion jouet en position, les enfants peuvent s’amuser à baisser les pieds de la grue, faire pivoter et étendre la flèche ou à monter et descendre le treuil

- Il inclut les minifigures du conducteur et de l’opérateur de la grue ainsi que des accessoires : une clé, un talkie-walkie et 2 casques de sécurité pour un jeu de rôle réaliste

- Ce jouet de construction inclut une plaque de route LEGO City qui peut être placée grâce au treuil puis utilisée pour connecter l’ensemble à d’autres sets LEGO

- Construire sa ville n’a jamais été aussi amusant ! Lorsque la mission est remplie, sécurisez le crochet du treuil et dirigez-vous vers le prochain travail

Features

- En selle ! Les poneys dans leur enclos sont impatients de galoper avec les enfants.

- Après la balade, il faudra récupérer la nourriture, les accessoires de toilettage qui sont dans la grange et les boxes.

- A partir de 3 ans.

- A partir de 5 ans.

Features

- Qui remportera la bataille ?

- Après des décennies de paix dans le royaume de Novelmore, le conflit reprend entre les chevaliers et les rebelles !

- Convient aux enfants à partir de 5 ans.

- Le coffret comprend les quatre personnages Novelmore, le château et de nombreux accessoires. Dimensions :79 x 57 x 44 cm (LxPxH)

- Rejoins les aventures des courageux chevaliers !

Features

- Contient 4 personnages un camion et un hélicoptère

- Le numéro de la plaque apparait en frottant

- Le grappin de l'hélicoptère est fonctionnel

- Accompagnez les policiers dans toutes leurs aventures avec Playmobil

Features

- Plaisir de jeu pour les petits policiers : camion Playmobil avec effets sonores et lumineux et de nombreux accessoires pour une reproduction fidèle aux détails

- Équipe SEK avec 3 policiers, espace pour 4 figurines, toit amovible, 2 sirènes, équipement SEK, etc Compatible avec le bateau pneumatique SEK (9362)

- Jeu de figurines pour enfants à partir de 5 ans : idéal pour les mains des enfants grâce à sa taille adaptée à l'âge et au toucher agréable avec bords arrondis

- Utilisation quotidienne : instructions de montage avec les parents, qualité et design robuste, nettoyage des pièces (sans autocollant ni électronique) sous l'eau courante sans produits chimiques

Features

- Plaisir de jeu pour les petits astronautes : Fusée Playmobil Space Mars avec de nombreux personnages et accessoires ainsi que des effets de lumière et de bruit cool

- Véritable rampe de démarrage, plateforme de maintenance mobile, capsule amovible pouvant être fixée sur Mars-Station 9487, extensible avec destructeur de météoroïdes (9490)

- Jeu de figurines pour enfants à partir de 6 ans : idéal pour les mains des enfants grâce à sa taille adaptée à l'âge et au toucher agréable avec bords arrondis

- Utilisation quotidienne : instructions de montage avec les parents, qualité et design robuste, nettoyage des pièces (sans autocollants) sous l'eau courante sans produits chimiques

- Couleur: Couleuré

Features

- Produit vendu avec garantie du fabricant (minimum 1 an) inclus.

- Produkt mit Minimum 1 Jahr Garantie.

- Produit en vente avec une garantie d'un año.

- Produit vendu exclusivement par le fabricant du fabricant.

- Produit vendu avec une garantie d'un an.

Features

- Plaisir de jeu pour les petits héros du quotidien : salle de gym Playmobil

- Équipement pour différents sports de ballon, avec affichage du niveau de jeu

- Jeu de figurines pour enfants à partir de 5 ans

- Utilisation quotidienne : instructions de montage avec les parents

- Contenu de la livraison : 1 salle de gym Playmobil City Life

Features

- Comprend quatre figurines : deux policiers et deux voleurs, plus une figurine de chien policier.

- Comprend un poste de commandement mobile, une moto de police et le tout-terrain des bandits.

- Le poste de commandement mobile comprend une cabine détachable, une cellule de prison avec une fonction d'évasion et de la place pour deux figurines, une salle de contrôle avec des écrans, une antenne parabolique sur le toit, un bureau, un siège et une zone de stockage pour la moto et des outils à l'arrière de la remorque.

- Le tout-terrain des bandits comprend une chaine et un crochet.

- Attache le crochet et la chaîne aux barreaux de la porte de la prison pour que le bandit s’évade.

Guide d’achat de Playmobil Station Service 2022

J’ai passé beaucoup de temps à inclure le Playmobil Station Service ci-dessus. Juste pour mentionner, j’ai regardé 24 heures, 182 Produit à acheter et tester 5 de Playmobil Station Service que j’ai répertorié.

Lors de l’achat d’un Playmobil Station Service, il y a toujours quelques points à garder à l’esprit. Je veux le partager avec vous. Si vous n’êtes pas convaincu par la liste ci-dessus, vous pouvez vérifier ces facteurs et trouver Playmobil Station Service qui correspond le mieux à vos besoins. Alors devrais-je commencer?

1er prix

Indépendamment de ce que vous achetez, le prix du produit est l’une des choses les plus importantes et il en va de même pour Playmobil Station Service. La plupart des Playmobil Station Service s sont dans la fourchette de prix allant du haut au bas. Le meilleur Playmobil Station Service est répertorié en haut de la liste. Si le budget n’a pas d’importance, je vous recommande de choisir le premier produit.

Vous pouvez opter pour la deuxième place. C’est aussi bon que le premier, mais cela coûte beaucoup moins cher. Cependant, si le budget est un gros problème et que vous recherchez le Playmobil Station Service le moins cher, vous devriez en choisir un qui coûte environ.

2. Avez-vous ce dont vous avez besoin?

Il est important que le Playmobil Station Service que vous achetez contienne toutes les fonctionnalités que vous recherchez. Parce que si vous ne répondez pas à vos besoins, comment serait-ce le mieux pour vous? Si vous cherchez quelque chose d’avenir. Le premier modèle que j’ai répertorié est le meilleur de tous les temps et possède toutes les fonctionnalités que vous devriez rechercher dans Playmobil Station Service.

Faites une liste de tous les éléments que vous recherchez dans Playmobil Station Service, puis comparez-les aux modèles répertoriés. S’il répond à vos exigences fonctionnelles, vous devriez vérifier le prix. Si cela correspond à votre budget, découvrez les autres avantages de Playmobil Station Service. Si vous avez des avantages supplémentaires qui pourraient vous être utiles, bravo! Vous venez de trouver le meilleur test Playmobil Station Service disponible pour votre budget.

3. La marque est importante!

Je recommande toujours à mes lecteurs de choisir Playmobil Station Service qui provient d’une marque bien connue. Parce que non seulement il sera excellent en termes de qualité du produit, mais il offrira également un meilleur support client, ce qui peut être utile si vous rencontrez un problème avec le mot clé Playmobil Station Service à l’avenir. Une marque peut être géniale aux États-Unis ou dans le monde, mais si elle n’offre pas de service près de chez vous, cela peut être un problème. Par conséquent, lors du choix d’une marque, assurez-vous que le service client ou le centre de service est à proximité.

4. Vérifiez les offres

À l’époque, vous deviez vous rendre dans différents magasins pour connaître le prix exact de Playmobil Station Service, et dans certains cas, il y avait très peu de magasins locaux. Cependant, avec une augmentation des sites de commerce électronique comme Amazon US, vous pouvez toujours obtenir le meilleur test Playmobil Station Service à un prix très fiable. Pour cette raison, j’ai inclus le lien vers la liste des produits Amazon. Si ce n’est pas urgent, vous pouvez attendre quelques jours pour vérifier.

5. Articles de garantie!

Les Playmobil Station Service s de marques connues ne sont pas facilement endommagés, et même s’ils le font, il y a une garantie que vous pouvez réparer gratuitement s’il y a un problème avec le fabricant ou un dysfonctionnement sans raison. Cependant, si vous achetez Playmobil Station Service s auprès de marques inconnues qui ne sont pas garanties, il y a de fortes chances que vous finissiez par dépenser beaucoup en réparations et en maintenance.

6. Lire les avis

La meilleure façon de reconnaître le mot clé Playmobil Station Service est d’essayer ou de l’utiliser. Mais ce n’est pas possible. Cependant, il existe de nombreux avis clients expliquant les avantages et les inconvénients qui peuvent être vraiment utiles. Étant donné que cet article vous aide à trouver le meilleur test Playmobil Station Service, je n’arrive pas à finir d’écrire des critiques détaillées pour chacun des produits. Pour cette raison, jusqu’à ce que je reçoive des avis détaillés sur les produits, ma suggestion passerait par les avis clients sur Amazon.

7. Vendeur fiable

Ce n’est généralement pas le cas, mais j’ai eu de mauvaises expériences à la recherche d’un Playmobil Station Service sur le marché hors ligne. Ils m’ont dit que le modèle que j’achète provenait d’une marque bien connue. Après l’avoir utilisé pendant 2 mois lorsque j’ai rencontré un problème avec le produit, j’ai contacté le centre de service et j’ai été informé que le Playmobil Station Service que je portais n’était pas fait pour vous par le service et qu’il s’agissait d’une première copie.

Suite à mes conseils, je voudrais vous demander de vous assurer que vous achetez auprès de vendeurs réputés comme Amazon et d’autres magasins populaires qui offrent un excellent support client! Dans le cas d’une telle arnaque, vous pouvez contacter Amazon – signaler une activité frauduleuse, aider d’autres personnes à éviter l’achat et même obtenir un remboursement.

Jugement

J’espère pouvoir vous aider à trouver le meilleur test Playmobil Station Service aux États-Unis pour 2022. Écrivez un commentaire si cela vous a été utileF